História de hardware de computação

Fundo para as escolas Wikipédia

Arranjar uma seleção Wikipedia para as escolas no mundo em desenvolvimento sem internet foi uma iniciativa da SOS Children. Clique aqui para saber mais sobre apadrinhamento de crianças.

| História da computação |

|---|

| Ferragens |

|

| Ciência da Computação |

|

| Conceitos modernos |

|

| Timeline da computação |

|

|

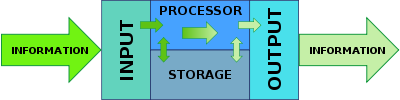

Hardware de computação evoluíram a partir de máquinas que impõem medidas manual separado para realizar cada operação aritmética, para máquinas de cartões perfurados, e depois para computadores de programa armazenado. A história dos computadores de programa armazenado relaciona primeiro a arquitetura de computadores, ou seja, a organização das unidades para executar entrada e saída, para armazenar dados e para funcionar como um mecanismo integrado.

Antes do desenvolvimento do computador de uso geral, a maioria dos cálculos foram feitos por seres humanos. Ferramentas mecânicas para ajudar os seres humanos com cálculos digitais foram então chamados de "máquinas de calcular", por nomes de proprietários, ou mesmo como eles estão agora, calculadoras . Era aqueles humanos que usavam as máquinas que foram, então, chamados computadores. Além de numerais escritos, as primeiras ajudas à computação eram dispositivos puramente mecânicos que exigiram ao operador para configurar os valores iniciais de uma operação aritmética elementar, em seguida, manipular o dispositivo para obter o resultado. Um exemplo sofisticado (e relativamente recente) é o régua de cálculo no qual os números são representados como comprimentos em uma escala logarítmica e cálculo é feito através da criação de um cursor e alinhando escalas móveis, assim adicionando esses comprimentos. Números poderia ser representada numa forma contínua "análogo", por exemplo, uma tensão ou alguma outra propriedade física foi ajustado para ser proporcional ao número. Computadores analógicos, como aqueles projetados e construídos por Vannevar Bush antes da Segunda Guerra Mundial eram desse tipo. Números pode ser representada sob a forma de dígitos, manipuladas automaticamente por um mecanismo mecânico. Embora esta última abordagem necessária mecanismos mais complexos, em muitos casos, feitas para uma maior precisão dos resultados.

Nos Estados Unidos, o desenvolvimento do computador foi impulsionado pelo investimento maciço do governo na tecnologia para aplicações militares durante a Segunda Guerra Mundial e depois da Guerra Fria. O último confronto superpotência tornou possível para os fabricantes locais a transformar suas máquinas em produtos comercialmente viáveis. Foi a mesma história na Europa, onde a adoção de computadores começou em grande parte através de medidas pró-ativas tomadas pelos governos nacionais para estimular o desenvolvimento e implantação da tecnologia.

A invenção de amplificadores eletrônicos feitos máquinas de calcular muito mais rápido do que seus antecessores mecânicos ou eletromecânicos. Tubo de vácuo (válvula thermionic) amplificadores deu lugar ao estado sólido transistores e, em seguida rapidamente para circuitos integrados que continuam a melhorar, colocando milhões de interruptores elétricos (tipicamente transistores) em uma única peça elaborada manufacturado de semi-condutores do tamanho de uma unha. Ao derrotar o tirania dos números, circuitos integrados feitos de alta velocidade e computadores digitais de baixo custo uma commodity generalizada. Há um esforço em curso para tornar o hardware do computador mais rápido, mais barato, e capaz de armazenar mais dados.

Hardware de computação tornou-se uma plataforma para outras utilizações que não mero cálculo, tais como automação de processos, comunicações electrónicas, controle de equipamento, entretenimento, educação, etc. Cada campo, por sua vez impôs as suas próprias exigências em matéria de hardware, que evoluiu em resposta àqueles requisitos, tais como o papel da tela sensível ao toque para criar uma mais intuitiva e interface de usuário natural.

Como todos os computadores dependem de armazenamento digital, e tendem a ser limitados pelo tamanho e velocidade de memória, a história de de armazenamento de dados do computador está ligado ao desenvolvimento de computadores.

Abertura de verdade hardware

Os dispositivos têm sido utilizados para ajudar a computação durante milhares de anos, a maioria usando um-para-um com a correspondência dedos. O dispositivo de contagem mais antigo provavelmente era uma forma de vara contagem. Posteriores de manutenção de registros auxiliares em todo o Crescente Fértil incluídos cálculos (esferas de argila, cones, etc.) que representava a contagem de itens, provavelmente gado ou grãos, selados em contentores. O uso de contando hastes é um exemplo.

O ábaco foi antecipada utilizada para tarefas aritméticas. O que hoje chamamos o Ábaco romano foi utilizado em Babilônia tão cedo quanto 2400 aC. Desde então, muitas outras formas de placas Reckoning ou tabelas foram inventados. Em um europeu medieval casa de contagem, um pano checkered seria colocado sobre uma mesa, e marcadores movimentados em-lo de acordo com certas regras, como uma ajuda para calcular somas de dinheiro.

Vários computadores analógicos foram construídos em épocas antigas e medievais para executar cálculos astronômicos. Estes incluem o Mecanismo de Antikythera eo astrolábio da Grécia antiga (c. 150-100 aC), que são geralmente considerados como os primeiros computadores conhecidos analógicos mecânicos. Heron de Alexandria (c. 10-70 dC) fez muitos dispositivos mecânicos complexos, incluindo autômatos e um carrinho programável. Outras versões iniciais de dispositivos mecânicos usados para executar um ou outro tipo de cálculos incluem o planisfério e outros dispositivos de computação mecânicos inventados por Abū rayhan Al-Biruni (c 1000 AD.); o equatorium e astrolábio independente de latitude universal por Abū Ishaq Ibrahim al-Zarqali (c AD 1015.); os computadores analógicos astronômicos de outro medieval Astrônomos e engenheiros muçulmanos; e o relógio astronômico torre de Su Song (c. 1090 AD), durante a Dinastia Song .

Matemático escocês e físico John Napier observou a multiplicação e divisão de números poderia ser realizada por adição e subtracção, respectivamente, dos logaritmos das esses números. Ao produzir as primeiras tabelas logarítmicas Napier necessário para realizar muitas multiplicações, e foi neste momento que ele projetou Os ossos de Napier, um dispositivo de ábaco do tipo usado para multiplicação e divisão. Desde números reais podem ser representados como distâncias ou intervalos em uma linha, a régua de cálculo foi inventado na década de 1620 para permitir operações de multiplicação e divisão a ser realizado significativamente mais rápido do que era possível anteriormente. As réguas de cálculo foram utilizados por gerações de engenheiros e outros profissionais da área matematicamente envolvidos, até a invenção da calculadora de bolso .

Wilhelm Schickard, um alemão polímata, projetado um relógio de cálculo em 1623. Ele fez uso de uma engrenagem de um único dente que não era uma solução adequada para um mecanismo de transporte em geral. Um incêndio destruiu a máquina durante a sua construção em 1624 e Schickard abandonou o projeto. Dois esboços de que foram descobertos em 1957, tarde demais para ter qualquer impacto sobre o desenvolvimento de calculadoras mecânicas.

Em 1642, quando ainda era um adolescente, Blaise Pascal iniciou alguns trabalhos pioneiros sobre máquinas de calcular e depois de três anos de esforço e 50 protótipos ele inventou o calculadora mecânica. Ele construiu vinte destas máquinas (chamado Calculadora de Pascal ou Pascaline), nos dez anos seguintes. Nove Pascalines sobreviveram, a maioria dos quais estão em exposição nos museus europeus.

Gottfried Wilhelm von Leibniz inventou o Pisou Reckoner e sua cilindros famosos ao redor de 1672, enquanto a adição de multiplicação direta e divisão para a Pascaline. Leibniz uma vez disse que "é indigna de homens excelentes para perder horas como escravos no trabalho de cálculo que poderia seguramente ser relegado para qualquer outra pessoa, se foram usadas máquinas."

Por volta de 1820, Charles Xavier Thomas de Colmar criou a primeira bem sucedida, calculadora mecânica produzida em massa, o Thomas Arithmometer, que poderia adicionar, subtrair, multiplicar e dividir. Foi baseado principalmente no trabalho de Leibniz. Calculadoras mecânicas, como a base dez addiator, o Comptometer, o Monroe, o Curta eo Addo-X permaneceu em uso até a década de 1970. Leibniz também descreveu o sistema binário , um ingrediente central de todos os computadores modernos. No entanto, até a década de 1940, muitos projetos subsequentes (incluindo Charles Babbage máquinas 's de 1822 e até ENIAC de 1945) foram baseados no sistema decimal; Contadores anel do ENIAC emulado o funcionamento das rodas de dígitos de uma máquina de adição mecânica.

No Japão, Ryoichi Yazu patenteou uma calculadora mecânica chamada de Yazu Arithmometer em 1903. Ela consistia de um único cilindro e 22 engrenagens, e empregou a base-2 e base-5 sistema de número misto familiar aos usuários do soroban (ábaco japonês). Carry e no final do cálculo foram determinados automaticamente. Mais de 200 unidades foram vendidas, principalmente para órgãos governamentais, como o Ministério da Guerra e estações experimentais agrícolas.

1801: A tecnologia de cartões perfurados

Em 1801, Joseph-Marie Jacquard desenvolveu um tear em que o padrão a ser tecida foi controlada pela cartões perfurados. A série de cartões podem ser alterados sem alterar o design mecânico do tear. Este foi um marco na programação. Sua máquina foi uma melhoria em relação tecelagem teares semelhante. Cartões perfurados foram precedidos por bandas perfurados, como na máquina proposta pela Basile Bouchon. Estas bandas iria inspirar informação de gravação para pianos automáticos e, mais recentemente, NC máquinas-ferramentas.

Em 1833, Charles Babbage transferiu-se de desenvolver a sua motor de diferença (para cálculos de navegação) para um projeto de propósito geral, a Máquina Analítica, que atraiu diretamente em cartões perfurados de Jacquard para seu armazenamento programa. Em 1837, Babbage descreveu sua máquina analítica. Era um computador programável de propósito geral, empregando cartões perfurados para entrada e uma máquina a vapor para o poder, utilizando as posições de engrenagens e eixos para representar números. Sua idéia inicial era usar punch-cards para controlar uma máquina que poderia calcular e imprimir tabelas logarítmicas com enorme precisão (uma máquina de propósito específico). A idéia de Babbage logo se transformaram em um computador programável de propósito geral. Enquanto seu projeto era de som e os planos eram provavelmente correto, ou pelo menos debuggable, o projeto foi retardado por vários problemas, incluindo litígios com as partes principais de construção maquinista para ele. Babbage era um homem difícil de trabalhar e discutiu com todos. Todas as peças para sua máquina tinha de ser feito à mão. Pequenos erros de cada item pode resumir às vezes para causar grandes discrepâncias. Em uma máquina com milhares de peças, o que exigiu estas peças a ser muito melhor do que as tolerâncias habituais necessários no momento, este foi um grande problema. O projeto dissolvido em disputas com o artesão que construiu partes e terminou com a decisão do Governo britânico de cessar o financiamento. Ada Lovelace, Lord Byron filha, traduzido e acrescentou notas para o "Esboço da Máquina Analítica" por Federico Luigi, Conte Menabrea. Esta parece ser a primeira descrição publicada de programação.

Uma reconstrução da Diferença Engine II, um projeto mais adiantado, mais limitada, está operacional desde 1991, no Museu da Ciência de Londres. Com algumas mudanças triviais, ele funciona exatamente como Babbage projetou e mostra que idéias do projeto de Babbage estavam corretas, apenas muito à frente de seu tempo. O museu usado controlados por computador máquinas-ferramentas para construir as peças necessárias, usando tolerâncias um bom maquinista do período teria sido capaz de alcançar. O fracasso de Babbage para completar a máquina analítica pode ser principalmente atribuído a dificuldades não só da política e financiamento, mas também ao seu desejo de desenvolver um computador cada vez mais sofisticados e de avançar mais rapidamente do que ninguém poderia seguir.

Uma máquina baseado no motor de diferença de Babbage foi construída em 1843 por Por Georg Scheutz e seu filho Edward. Um mecanismo de cálculo Scheutzian melhorou foi vendido para o governo britânico e um modelo mais tarde foi vendido para o governo americano e estes foram utilizados com sucesso na produção de tabelas logarítmicas.

Seguindo Babbage, embora inconsciente de seu trabalho anterior, foi Percy Ludgate, um contador de Dublin, na Irlanda. Ele independentemente projetou um computador mecânico programável, que ele descreveu em um trabalho que foi publicado em 1909.

1880: o armazenamento de dados de cartões perfurados

No final de 1880, o americano Herman Hollerith inventou o armazenamento de dados num suporte que pode ser lido por uma máquina. Usos anteriores de máquina da mídia legível tinha sido para o controle ( autômatos, tais como rolos de piano ou teares), não dados. "Depois de alguns ensaios iniciais com fita de papel, ele se estabeleceu em cartões perfurados ... "Hollerith chegou a usar cartões perfurados depois de observar como condutores da estrada de ferro codificado características pessoais de cada passageiro com socos em seus bilhetes. Para processar esses cartões perfurados que ele inventou o tabulator, eo máquina de soco chave. Estes três invenções eram a fundação da indústria de processamento de informação moderna. Suas máquinas usadas mecânica relés (e solenóides) para incrementar contadores mecânicos. Método de Hollerith foi utilizado no United States Census 1890 e os resultados concluídos foram "... acabados meses antes do previsto e muito abaixo do orçamento". Na verdade, o censo foi processado anos mais rápido do que o censo anterior tinha sido. A companhia de Hollerith, eventualmente, tornou-se o núcleo da IBM . IBM desenvolveu a tecnologia de cartões perfurados em uma poderosa ferramenta para processamento de dados de negócios e produziu uma extensa linha de equipamentos de registo da unidade. Em 1950, o cartão IBM tornou-se onipresente na indústria e no governo. A advertência impressa na maioria das placas destinadas à circulação como documentos (cheques, por exemplo), "Não dobre, fuso ou mutilar ", se tornou um slogan para a era pós-Segunda Guerra Mundial.

Artigos de Leslie Comrie sobre métodos de cartões perfurados e Publicação de WJ Eckert de Métodos perfuradas cartão em Computação Científica em 1940, técnicas de cartões perfurados descritos suficientemente avançados para resolver algumas equações diferenciais ou executar multiplicação e divisão usando flutuante representações pontuais, tudo sobre cartões perfurados e máquinas de registo da unidade. Essas mesmas máquinas tinham sido utilizados durante a Segunda Guerra Mundial para tratamento estatístico de criptografia. Na imagem do tabulator (veja à esquerda), anote o painel de controle, que é visível no lado direito da tabulação. Uma fileira de interruptores é acima do painel de controle. O Thomas J. Watson Astronomical Computing Bureau, Universidade de Columbia realizada cálculos astronómicas que representam o estado da arte em computação.

Programação de computadores na era de cartões perfurados era centrada no "centro de informática". Os usuários de computadores, por exemplo, ciência e engenharia estudantes em universidades, iria apresentar seus trabalhos de programação para o seu centro de computador local sob a forma de uma plataforma de cartões perfurados, um cartão por linha de programa. Eles, então, teve de esperar para o programa a ser lido em, em fila para processamento, compilado e executado. Na devida altura, uma cópia impressa de quaisquer resultados, marcado com a identificação do remetente, seria colocado em uma bandeja de saída, tipicamente no lobby centro de informática. Em muitos casos, estes resultados seria apenas uma série de mensagens de erro, exigindo ainda outra ciclo editar-punch-compilar prazo. Cartões perfurados ainda são utilizados e fabricados para este dia, e as suas dimensões distintas (e capacidade de 80 colunas) ainda pode ser reconhecida em formulários, registros e programas em todo o mundo. Eles são do tamanho de papel-moeda americana no tempo de Hollerith, uma escolha que ele fez porque já havia equipamento disponível para lidar com contas.

Calculadoras de desktop

Por volta do século 20, calculadoras mecânicas anteriores, caixas registadoras, máquinas de contabilidade, e assim por diante foram redesenhadas para utilizar motores elétricos, com a posição das engrenagens como a representação para o estado de uma variável. A palavra "computador" era um cargo atribuído a pessoas que usaram estas calculadoras para realizar cálculos matemáticos. Na década de 1920 O interesse de Lewis Fry Richardson na previsão do tempo levou a propor computadores e humanos análise numérica para modelar o clima; até hoje, os computadores mais poderosos da Terra são necessários para modelar adequadamente o seu tempo usando o Equações de Navier-Stokes.

Empresas como a Friden, Calculadora e Marchant Monroe fez área de trabalho mecânico calculadoras da década de 1930 que poderiam adicionar, subtrair, multiplicar e dividir. Durante o Projeto Manhattan, futuro ganhador do Nobel Richard Feynman foi o supervisor de computadores humanos que compreenderam o uso de equações diferenciais que estavam sendo resolvidos para o esforço de guerra.

Em 1948, a Curta foi introduzido. Este foi um pequeno portátil calculadora,, mecânica, que era do tamanho de um moedor de pimenta. Ao longo do tempo, durante os anos 1950 e 1960 uma variedade de diferentes marcas de calculadoras mecânicas apareceram no mercado. A primeira calculadora de desktop all-eletrônico foi o britânico ANITA Mk.VII, que utilizou um Exibição tubo nixie e 177 subminiature tubos Thyratron. Em junho de 1963, Friden introduziu o quatro funções CE-130. Ele tinha uma capacidade de design all-transistor, de 13 dígitos em um de 5 polegadas (130 mm) CRT, e introduziu Notação polonesa reversa (RPN) para o mercado de calculadora a um preço de $ 2200. O modelo EC-132 adicionou raiz quadrada e funções recíprocas. Em 1965, Wang Laboratories produziu o LOCI-2, uma calculadora de desktop transistorizado de 10 dígitos que usou um tubo de Nixie exibição e poderia computar logaritmos .

Nos primeiros dias de computadores de tubo de vácuo binários, a sua fiabilidade foi ruim o suficiente para justificar a comercialização de um octal versão mecânica ("Binário Octal") da calculadora de mesa Marchant. Foi destinado a controlar e verificar os resultados do cálculo de tais computadores.

Computadores analógicos avançadas

Antes da Segunda Guerra Mundial , mecânica e elétrica computadores analógicos foram considerados o "estado da arte", e muitos pensavam que eram o futuro da computação. Computadores analógicos aproveitar as fortes semelhanças entre a matemática das propriedades de pequena escala posição eo movimento das rodas ou a tensão ea corrente de componentes eletrônicos e-matemática de outros fenômenos físicos, por exemplo, trajetórias balísticas, inércia, ressonância, transferência de energia, impulso, e assim por diante. Eles modelar fenômenos físicos com elétrica e tensões correntes como as grandezas analógicas.

Centralmente, estes sistemas analógicos trabalhar criando elétrica ' análogos 'de outros sistemas, permitindo aos usuários prever o comportamento dos sistemas de interesse, observando os análogos elétricos. O mais útil dos analogias foi a maneira como o comportamento em pequena escala pode ser representada com equações integrais e diferenciais, e poderia, portanto, ser utilizado para resolver essas equações. Um exemplo de um tal engenhosa máquina, usando água como a quantidade análoga, foi o integrador de água construído em 1928; um exemplo eléctrica é a Máquina Mallock construído em 1941. A planímetro é um dispositivo que faz integrais, utilizando distância como a quantidade análoga. Ao contrário dos computadores digitais modernos, computadores analógicos não são muito flexíveis, e têm de ser religado manualmente para mudá-los a partir de trabalho sobre um problema para outro. Computadores analógicos tinham uma vantagem sobre os primeiros computadores digitais em que eles poderiam ser usados para resolver problemas complexos usando análogos de comportamento, enquanto as primeiras tentativas de computadores digitais eram bastante limitadas.

Alguns dos computadores analógicos mais amplamente implementados incluído dispositivos para armas destinadas, como o Bombsight Norden, e sistemas de controle de fogo, tais como Argo sistema de Arthur Pólen para os navios de guerra. Alguns permaneceram em uso por décadas após a Segunda Guerra Mundial; o Computador de Controle Mark I fogo foi implantado pela Marinha dos Estados Unidos em uma variedade de navios de destruidores para navios de guerra . Outros computadores analógicos incluído o Heathkit CE-1, e o hidráulica MONIAC computador que modelou fluxos econométricos.

A arte de computação analógica mecânico atingiu o seu apogeu com a analisador diferencial, construído por HL Hazen e Vannevar Bush em MIT começando em 1927, que por sua vez construída sobre os integradores mecânicos inventados em 1876 por James Thomson e os amplificadores de torque inventados por HW Nieman. Uma dúzia desses dispositivos foram construídos antes de sua obsolescência era óbvio; o mais potente foi construído no Universidade da Pensilvânia Moore Faculdade de Engenharia Elétrica, onde o ENIAC foi construído. Computadores eletrônicos digitais como o ENIAC significava o fim para a maioria das máquinas de computação analógicos, mas os computadores analógicos híbrido, controlados por eletrônica digital, permaneceu em uso substancial em 1950 e 1960, e mais tarde em algumas aplicações especializadas.

Computação digital eletrônico início

A era da computação moderna começou com uma enxurrada de desenvolvimento antes e durante a Segunda Guerra Mundial.

No primeiro componentes eletromecânicos foram empregados como relés. George Stibitz é reconhecido internacionalmente como um dos pais do computador digital moderno. Enquanto trabalhava nos Laboratórios Bell em novembro de 1937, Stibitz inventou e construiu uma calculadora de relé que ele apelidado de "Modelo K" (de "mesa da cozinha", em que ele tinha montado ele), que foi o primeiro a calcular usando forma binária .

No entanto, elementos dos circuitos eletrônicos substituíram seus equivalentes mecânicos e electromecânicos, e cálculos digitais substituído cálculos analógicos. Máquinas como o Z3, o Atanasoff-Berry Computer, o Computadores Colossus, ea ENIAC foram construídas à mão usando circuitos contendo relés ou as válvulas (tubos de vácuo), e usado frequentemente cartões perfurados ou fita de papel perfurado para entrada e como o principal (não volátil) meio de armazenamento. A definição de um único ponto na série como o "primeiro computador" perde muitas sutilezas (consulte a tabela "Definição de características de alguns computadores digitais início da década de 1940" abaixo).

Turing

Alan Turing 1936 papel 's provou extremamente influente em computação e ciência da computação de duas maneiras. Seu principal objetivo era provar que houve problemas (ou seja, a problema da paragem) que não pode ser resolvido por qualquer processo sequencial. Ao fazê-lo, Turing fornecida uma definição de um computador universal que executa um programa armazenado na fita. Esta construção passou a ser chamado de Máquina de Turing. Salvo as limitações impostas pelos seus memória armazena finitos, computadores modernos estão a ser dito Turing completo, o que quer dizer, eles têm algoritmo capacidade de execução de um equivalente máquina universal de Turing.

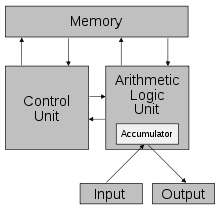

Para uma máquina de computação a ser uma prática computador de uso geral, deve haver algum mecanismo de leitura-escrita conveniente, fita perfurada, por exemplo. Com o conhecimento teórico da "máquina de computação universal 'de Alan Turing John von Neumann definida uma arquitetura que utiliza a mesma memória tanto para armazenar programas e dados: praticamente todos os computadores contemporâneos usar essa arquitetura (ou alguma variante). Embora seja teoricamente possível para implementar um computador completo inteiramente mecanicamente (como o projeto de Babbage mostrou), eletrônica possibilitou a velocidade e, posteriormente, a miniaturização que caracterizam computadores modernos.

Havia três fluxos paralelos de desenvolvimento do computador na época da II Guerra Mundial; a primeira corrente amplamente ignorado, e a segunda corrente mantida deliberadamente segredo. O primeiro foi o trabalho alemão de Konrad Zuse. A segunda foi o desenvolvimento segredo dos computadores Colossus no Reino Unido. Nenhuma delas tinha muita influência sobre os vários projetos de computação nos Estados Unidos, mas alguns da tecnologia LED, através de Turing e outros, para o primeiro computador eletrônico comercial. A terceira corrente de desenvolvimento do computador foi Eckert e Mauchly e ENIAC do EDVAC, o que foi amplamente divulgado.

Zuse

Trabalhando em isolamento na Alemanha, Konrad Zuse começou a construção em 1936 de suas primeiras calculadoras Z-série que caracteriza a memória e (inicialmente limitada) programação. Zuse do puramente mecânico, mas já binário Z1, terminou em 1938, nunca funcionou de forma confiável devido a problemas com a precisão de peças.

Máquina depois de Zuse, o Z3, foi concluída em 1941. Foi baseado em relés de telefone e fez trabalho de forma satisfatória. O Z3 tornou-se, assim, em primeiro lugar controlado por programa, para todos os fins, computador digital funcional do mundo. Em muitos aspectos, foi bastante semelhante às máquinas modernas, inúmeros avanços pioneiros, como números de ponto flutuante. Substituição do sistema decimal difícil de implementar (utilizado em Charles Babbage projeto mais adiantado 's) pelo simples binário sistema significava que as máquinas de Zuse eram mais fáceis de construir e potencialmente mais confiável, tendo em conta as tecnologias disponíveis naquele momento.

Os programas foram introduzidos Z3 em filmes perfurados. Saltos condicionais estavam faltando, mas desde a década de 1990 que tenha sido provado teoricamente que Z3 ainda era um computador universal (como sempre, ignorando as limitações de armazenamento físico). Em dois 1936 pedidos de patente, Konrad Zuse também antecipou que as instruções de máquina podem ser armazenados no mesmo armazenamento utilizado para dados-chave a percepção do que se tornou conhecido como o arquitetura de von Neumann, implementado pela primeira vez no British SSEM de 1948. Zuse também alegou ter projetado o primeiro de alto nível linguagem de programação , que ele chamou de Plankalkül, em 1945 (publicado em 1948), embora não foi implementado pela primeira vez em 1998 e novamente em 2000 por uma equipe em torno de Raúl Rojas no Universidade Livre de Berlim.

Zuse sofreu reveses durante a Segunda Guerra Mundial, quando alguns de seus máquinas foram destruídas no curso de Campanhas de bombardeio dos Aliados. Aparentemente, sua obra permaneceu praticamente desconhecida para os engenheiros no Reino Unido e EUA até muito mais tarde, embora pelo menos IBM estava ciente de como ele financiou a sua empresa startup do pós-guerra, em 1946, em troca de uma opção sobre patentes da Zuse.

Colosso

Durante a Segunda Guerra Mundial, os britânicos em Bletchley Park (40 milhas ao norte de Londres) alcançou um número de sucessos em quebrar as comunicações militares alemãs encriptadas. A máquina de criptografia alemão, Enigma , foi atacado com a ajuda de máquinas eletromecânicas chamado bombes. O bombe, projetado por Alan Turing e Gordon Welchman, após a criptografia polonês bomba por Marian Rejewski (1938), entrou em uso produtivo em 1941. Eles descartou possíveis configurações Enigma realizando cadeias de deduções lógicas implementadas eletricamente. A maioria das possibilidades levou a uma contradição, e os poucos remanescentes poderia ser testado com a mão.

Os alemães também desenvolveram uma série de sistemas de criptografia teletipo, bem diferente do Enigma. O Lorenz SZ 40/42 máquina foi usada para comunicações do Exército de alto nível, denominado "Atum" pelos britânicos. As primeiras interceptações de mensagens Lorenz começou em 1941. Como parte de um ataque ao Atum, Max Newman e seus colegas ajudaram a especificar a Colossus. O Mk I Colossus foi construída entre Março e Dezembro de 1943 por Tommy Flores e seus colegas da Post Office Estação de Pesquisa em Dollis Hill, em Londres e, em seguida, enviado para Bletchley Park em janeiro de 1944.

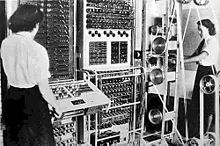

Colossus foi o primeiro dispositivo programável de computação eletrônica do mundo. É usado um grande número de válvulas (tubos de vácuo). Tinha input-fita de papel e foi capaz de ser configurado para executar uma variedade de lógicas booleanas operações sobre seus dados, mas não foi Turing completo. Nove Mk II Colossi foram construídos (O Mk I foi convertida em um Mk II fazendo dez máquinas no total). Detalhes de sua existência, design e uso foram mantidos em segredo bem na década de 1970. Winston Churchill emitido pessoalmente uma ordem para a sua destruição em pedaços não maiores do que a mão de um homem, para manter em segredo que os britânicos foram capazes de quebrar Lorenz durante o que se aproxima frio guerra. Duas das máquinas foram transferidos para o recém-formado GCHQ e os outros foram destruídos. Como resultado, as máquinas não foram incluídos em muitas histórias de computação. Uma cópia de trabalho reconstruída de uma das máquinas Colossus está agora em exposição em Bletchley Park.

Desenvolvimentos americanos

Em 1937, Claude Shannon mostrou que há uma one-to-one correspondência entre os conceitos de lógica booleana e de certos circuitos elétricos, agora chamado portas lógicas, que são agora onipresentes em computadores digitais. Em sua tese de mestrado em MIT, pela primeira vez na história, Shannon mostrou que relés eletrônicos e switches podem perceber a expressões de Álgebra booleana. Intitulado Uma análise simbólica de Relay e comutação de circuitos, a tese de Shannon essencialmente fundada prático projeto de circuito digital. George Stibitz completou um computador baseado no revezamento ele apelidado de "Modelo K" no Bell Labs, em Novembro de 1937. Bell Labs autorizou um programa de pesquisa completo no final de 1938 com Stibitz no leme. Seu Complex Calculator Número, completou 08 de janeiro de 1940, foi capaz de calcular números complexos . Numa demonstração ao Conferência da Sociedade Americana de Matemática em Dartmouth College em 11 de setembro de 1940, Stibitz foi capaz de enviar a calculadora do número complexo comandos remotos através de linhas telefônicas por um teletipo. Foi a primeira máquina de computação já utilizado remotamente, neste caso através de uma linha de telefone. Alguns participantes da conferência que presenciou a demonstração eram John von Neumann , John Mauchly, e Norbert Wiener, que escreveu sobre isso em suas memórias.

Em 1939, John Vincent Atanasoff e Clifford E. Berry da Universidade Estadual de Iowa desenvolveram o Atanasoff-Berry Computer (ABC), The Atanasoff-Berry Computer foi o primeiro computador digital eletrônico do mundo. O projeto usado mais de 300 tubos de vácuo e empregou condensadores fixos em um tambor rotativo mecanicamente para a memória. Embora a máquina ABC não era programável, foi o primeiro a utilizar válvulas electrónicas num adicionador. ENIAC co-inventor John Mauchly examinou o ABC em junho de 1941, e sua influência sobre o design da máquina ENIAC depois é uma questão de discórdia entre os historiadores de computador. O ABC foi em grande parte esquecido até que se tornou o foco da ação judicial Honeywell v. Sperry Rand , a decisão de que invalidou a patente do ENIAC (e vários outros) como, entre muitas razões, tendo sido antecipado pelo trabalho de Atanasoff.

Em 1939, o desenvolvimento começou nos laboratórios da IBM em Endicott no Harvard Mark I. Conhecido oficialmente como a Seqüência automática controlada Calculator, o Mark I foi um computador eletro-mecânico de propósito geral construída com financiamento IBM e com a assistência do pessoal da IBM, sob a direção de Harvard matemático Howard Aiken. Seu design foi influenciado pela máquina analítica de Babbage, usando aritmética e armazenamento rodas decimais e interruptores rotativos, além de relés eletromagnéticos. Foi programáveis através de fita de papel perfurado, e continha várias unidades de cálculo trabalhando em paralelo. Versões posteriores continham vários leitores de fita de papel ea máquina podia alternar entre leitores com base em uma condição. No entanto, o equipamento não era muito Turing completo. O Mark I foi transferida para a Universidade de Harvard e começou a operação maio 1944.

ENIAC

O ENIAC US-construído (Electronic Numerical Integrator and Computer) foi o primeiro computador eletrônico de uso geral. Combinou, pela primeira vez, a elevada velocidade de electrónica com a capacidade de ser programado para muitos problemas complexos. Pode adicionar ou subtrair 5.000 vezes por segundo, mil vezes mais rápido do que qualquer outra máquina. Ele também tinha módulos para multiplicar, dividir e raiz quadrada. Memória de alta velocidade era limitada a 20 palavras (aproximadamente 80 bytes). Construída sob a direcção de John Mauchly e J. Presper Eckert no Universidade da Pensilvânia, desenvolvimento e construção do ENIAC durou de 1943 a plena operação no final de 1945. A máquina foi enorme, pesando 30 toneladas, usando 200 quilowatts de energia elétrica e contidos mais de 18.000 tubos de vácuo, 1.500 relés, e centenas de milhares de resistores, capacitores, e indutores. Uma das grandes obras de engenharia foi para reduzir o desgaste do tubo, o que foi um problema comum nessa altura. A máquina estava em uso quase constante para os próximos dez anos.

ENIAC era inequivocamente um dispositivo de Turing completo. Pode calcular qualquer problema (que se encaixam na memória). Um "programa" do ENIAC, no entanto, foi definida pelos estados de seus cabos de rede e switches, muito longe do programa armazenado máquinas eletrônicas que vieram depois. Uma vez que um programa foi escrito, ele teve que ser ajustado mecanicamente na máquina. Seis mulheres fez a maior parte da programação do ENIAC. (Melhorias concluídas em 1948, foi possível executar programas armazenados definidos em função de memória da tabela, que fez a programação menos um "one-off" esforço, e mais sistemática).

Manchester "baby"

O Manchester Pequena Escala Experimental Machine, apelidado debebê, foi o primeiro do mundo computador de programa armazenado.Foi construído naUniversidade Victoria de Manchester porFrederic C. Williams,Tom Kilburn e Geoff Tootill, e correu o seu primeiro programa em 21 de junho de 1948.

A máquina não se destinava a ser um computador prático, mas em vez disso foi concebido como um testbed para o tubo de Williams, uma forma primitiva de memória do computador. Apesar de ser considerado "pequeno e primitivo" pelos padrões de sua época, era a primeira máquina trabalhando para conter todos os elementos essenciais para um computador eletrônico moderno. Assim que o SSEM tinha demonstrado a viabilidade de seu projeto, um projeto foi iniciado na universidade para desenvolvê-lo em um computador mais utilizável, o Manchester Mark 1. O Mark 1, por sua vez rapidamente se tornou o protótipo para o Ferranti Mark 1, o primeiro comercialmente disponível computador de uso geral do mundo.

O SSEM teve um 32 bocado comprimento de palavra e uma memória de 32 palavras. Como ele foi projetado para ser o mais simples possível computador de programa armazenado, as únicas operações aritméticas implementadas no hardware foram subtração e negação; outras operações aritméticas foram implementados em software. O primeiro dos três programas escritos para a máquina encontrada a maior divisor apropriada de 2 18 (262,144), um cálculo que era conhecido iria demorar muito tempo para ser executado e assim provar do computador fiabilidade-testando cada número inteiro de 2 18 - 1 para baixo, divisão como foi implementado por subtracção repetida do divisor. O programa consistiu de 17 instruções e correu por 52 minutos antes de chegar a resposta correta de 131.072, após a SSEM tinha realizado 3,5 milhões de operações (para uma velocidade de CPU efetiva de 1,1 Kips).

Características de computador adiantados

| Nome | Primeiro operacional | Sistema de numeração | Mecanismo Computing | Programação | Turing completa |

|---|---|---|---|---|---|

| Zuse Z3 (Alemanha) | Mai 1941 | Binário ponto flutuante | Electro-mecânica | Programa-controlado por um soco 35 milímetrosestoque filme (mas nenhum ramo condicional) | Em teoria( 1998) |

| Atanasoff-Berry Computer(US) | 1942 | Binário | Eletrônico | Finalidade não programável-single | Não |

| Colossus Mark 1(UK) | Fev 1944 | Binário | Eletrônico | Por cabos de correção e switches programa controlado | Não |

| Harvard Mark I - IBM ASCC(US) | Mai 1944 | Decimal | Electro-mecânica | Por 24 canais de programa controladofita de papel perfurado (mas nenhum ramo condicional) | Discutível |

| Colossus Mark 2(UK) | Junho 1944 | Binário | Eletrônico | Por cabos de correção e switches programa controlado | Em teoria(2011) |

| Zuse Z4(Alemanha) | Março 1945 | Binário de ponto flutuante | Electro-mecânica | Programa-controlado por um soco estoque de filme 35 mm | Sim |

| ENIAC(US) | Julho 1946 | Decimal | Eletrônico | Por cabos de correção e switches programa controlado | Sim |

| Manchester Pequena Escala Máquina Experimental (Baby)(UK) | Junho 1948 | Binário | Eletrônico | De programa armazenado namemória de tubo de raios catódicos Williams | Sim |

| Modificado ENIAC(US) | Setembro 1948 | Decimal | Eletrônico | Read-only mecanismo de programação armazenados usando as tabelas funcionar como programaROM | Sim |

| EDSAC(UK) | Mai 1949 | Binário | Eletrônico | De programa armazenado em mercúrioatraso linha memória | Sim |

| Manchester Mark 1(UK) | Outubro 1949 | Binário | Eletrônico | De programa armazenado na memória Williams tubo de raios catódicos ememória tambor magnético | Sim |

| CSIRAC(Austrália) | Novembro 1949 | Binário | Eletrônico | De programa armazenado na memória de linha de atraso de mercúrio | Sim |

Máquinas de primeira geração

Mesmo antes do ENIAC foi terminado, Eckert e Mauchly reconhecida suas limitações e começou o projeto de um computador de programa armazenado, EDVAC. John von Neumann foi creditado com um relatório amplamente divulgado descrevendo o projeto EDVAC em que ambos os programas e dados de trabalho eram armazenados em uma única loja, unificado. Este projeto básico, indicado a arquitetura de von Neumann, serviria como base para o desenvolvimento mundial dos sucessores de ENIAC. Nesta geração de equipamento de armazenagem temporária ou de trabalho foi fornecido por linhas de atraso acústicas, que utilizaram o tempo de propagação do som através de um meio tal como líquido de mercúrio (ou através de um fio) para armazenar dados brevemente. Uma série de impulsos acústicos são enviados ao longo de um tubo; depois de um tempo, como o pulso atingido a extremidade do tubo, o circuito detectado se o impulso representado um 1 ou 0 e fez com que o oscilador de re-enviar o pulso. Outros usaram tubos de Williams, que utilizam a capacidade de um pequeno tubo de raios catódicos (CRT) para armazenar e recuperar dados como áreas cobradas na tela de fósforo. Por volta de 1954, memória de núcleo magnético foi deslocando rapidamente a maioria das outras formas de armazenamento temporário, e dominaram o campo através de meados dos anos 1970.

EDVAC foi o primeiro computador de programa armazenado projetado; no entanto, não foi o primeiro a ser executado. Eckert e Mauchly deixou o projeto e sua construção fracassarem. A primeira máquina de von Neumann trabalho foi o Manchester "Baby" ou pequena escala Máquina Experimental, desenvolvido por Frederic C. Williams e Tom Kilburn na Universidade de Manchester em 1948 como uma cama de teste para o tubo de Williams; foi seguido em 1949 pelo computador Manchester Mark 1, um sistema completo, usando tubo de Williams e memória tambor magnético, ea introdução de registros de índice. O outro candidato ao título "primeiro computador digital de programa armazenado" tinha sido EDSAC, projetado e construído no Universidade de Cambridge . Operacional menos de um ano após o Manchester "Baby", foi também capaz de enfrentar problemas reais. EDSAC estava realmente inspirado por planos para EDVAC (Electronic Discrete Variable Automatic Computer), o sucessor do ENIAC; estes planos já estavam no local no momento ENIAC foi sucesso operacional. Ao contrário do ENIAC, que utilizava processamento paralelo, EDVAC usado uma única unidade de processamento. Este projeto era simples e foi o primeiro a ser implementado em cada onda sucessiva de miniaturização, e aumento da confiabilidade. Alguns vêem Manchester Mark 1 / EDSAC / EDVAC como o "Evas" a partir do qual quase todos os computadores atuais derivam sua arquitetura. Máquina da Universidade de Manchester se tornou o protótipo para o Ferranti Mark 1. O primeiro Ferranti Mark 1 máquina foi entregue à Universidade em Fevereiro de 1951 e pelo menos outras nove pessoas foram vendidos entre 1951 e 1957.

O primeiro computador programável universal na União Soviética foi criado por uma equipe de cientistas sob direção de Sergei Lebedev Alekseyevich de Kiev Instituto de Eletrotécnica, União Soviética (hoje Ucrânia ). O computador MESM ( МЭСМ , Pequeno eletrônicos máquina de calcular ) tornou-se operacional em 1950. tinha cerca de 6.000 tubos de vácuo e consumiu 25 kW de potência. Pode realizar aproximadamente 3.000 operações por segundo. Outra máquina precoce foi CSIRAC, um projeto australiano que correu o seu primeiro programa de teste em 1949. CSIRAC é o computador mais antigo ainda em existência ea primeira a ter sido usado para tocar música digital.

Computadores comerciais

O primeiro computador comercial foi o Ferranti Mark 1, que foi entregue à Universidade de Manchester em fevereiro de 1951. Ele foi baseado no Manchester Mark 1. As principais melhorias em relação ao Manchester Mark 1 estavam no tamanho do armazenamento primário (usando aleatório acesso Williams tubos), armazenamento secundário (utilizando um tambor magnético), um multiplicador mais rápido, e as instruções adicionais. O tempo de ciclo básico era de 1,2 milissegundos, e uma multiplicação pode ser concluído em cerca de 2,16 milissegundos. O multiplicador usado quase um quarto dos tubos de vácuo 4050 da máquina (válvulas). Uma segunda máquina foi adquirida pela Universidade de Toronto, antes que o projeto foi revisto para o Mark 1 Estrela. Pelo menos sete destas máquinas posteriores foram entregues entre 1953 e 1957, um deles a Shell laboratórios em Amsterdam .

Em outubro de 1947, os diretores da J. Lyons & Company, uma empresa de catering britânica famosa por suas casas de chá, mas com fortes interesses em novas técnicas de gestão de escritório, decidiu assumir um papel ativo na promoção do desenvolvimento comercial de computadores. O LEO I computador tornou-se operacional em abril de 1951 e correu do primeiro Ordinário mundo rotina computador escritório trabalho. Em 17 de Novembro 1951, a empresa J. Lyons começou a operação semanal de um trabalho valuations padaria na LEO (Lyons Electronic Office). Esta foi a primeira empresa a aplicação de ir ao vivo em um computador de programa armazenado.

Em junho de 1951, o UNIVAC I (Universal Automatic Computer) foi entregue ao o US Census Bureau. Remington Rand vendeu 46 máquinas em mais de US $ 1 milhão cada (8,84 milhões dólares americanos a partir de 2013). UNIVAC foi o primeiro computador "produzido em massa". Ela costumava 5.200 tubos de vácuo e consumiu 125 kW de potência. Seu armazenamento primário foi de acesso de série linhas de retardo de mercúrio capaz de armazenar 1.000 palavras de 11 dígitos decimais mais o sinal (palavras de 72 bits). Uma característica fundamental do sistema UNIVAC foi recentemente inventado um tipo de fita magnética de metal, e uma unidade de fita de alta velocidade, para o armazenamento não-volátil. A fita magnética ainda é usado em muitos computadores. Em 1952, a IBM anunciou publicamente o IBM 701 Máquina de processamento eletrônico de dados, a primeira na sua bem sucedida série 700/7000 e seu primeiro computador mainframe IBM. O IBM 704, introduzida em 1954, usou memória de núcleo magnético, que se tornou o padrão para máquinas de grande porte. O alto nível de uso geral implementado pela primeira linguagem de programação , Fortran, também estava sendo desenvolvido pela IBM para o 704 durante 1955 e 1956 e lançado no início de 1957. (1945 projeto de Konrad Zuse da linguagem de alto nível Plankalkül não foi implementado naquela época ) Um voluntário. grupo de usuários, que existe até hoje, foi fundada em 1955 para partilhar o seu software e experiências com o IBM 701.

IBM introduziu um computador menor, mais acessível em 1954, que provou ser muito popular. O 650 IBM pesava mais de 900 kg, a fonte de alimentação pesava cerca de 1350 kg e ambos foram realizadas em gabinetes separados de cerca de 1,5 metros por 0,9 metros por 1,8 metros. Custou US $ 500.000 (4270 mil dólares a partir de 2013) ou podia ser alugado por US $ 3.500 por mês (US $ 30 mil em 2013). Sua memória tambor era originalmente 2.000 palavras de dez dígitos, mais tarde expandido para 4.000 palavras. As limitações de memória, tais como esta eram a dominar a programação por décadas depois. As instruções do programa foram buscados no tambor giratório que o código funcionou. Execução usando a memória eficiente tambor foi fornecida por uma combinação de arquitetura de hardware: o formato de instrução incluído o endereço da próxima instrução; e software: Programa de montagem óptima simbólica, SOAP, instruções atribuídos aos endereços óptimas (na medida do possível por análise estática da fonte de programa). Assim, muitos foram instruções, quando necessário, localizado na linha seguinte do tambor para ser lido e não foi necessário um tempo de espera adicional para a rotação do tambor.

Em 1955, Maurice Wilkes inventou a microprogramação, que permite que a instrução de base definida para ser definido ou prorrogado por programas internos (agora chamado firmware ou microcódigo). Foi amplamente utilizado nas CPUs e unidades de ponto flutuante de mainframe e outros computadores, como o Manchester Atlas ea série IBM 360.

IBM introduziu o primeiroaparelho de armazenamento em disco (umaunidade de disco rígido), oIBM 350 RAMAC (método de acesso aleatório de Contabilidade e Controle), em 1956. Usando cinqüenta de 24 polegadas (610 milímetros) discos de metal, com 100 faixas de cada lado, foi capaz de armazenar 5megabytes de dados a um custo de US $ 10.000 por megabyte (US $ 80 mil em 2013).

Segunda geração: transistores

O bipolar transistor foi inventado em 1947. A partir de 1955 transistores substituídos tubos de vácuo em projetos de computador, dando origem à "segunda geração" de computadores. Inicialmente os únicos dispositivos disponíveis foram germânio transistores de ponto de contacto, que embora menos confiável do que os tubos de vácuo que substituir tinha a vantagem de consumir muito menos energia. O primeiro transistorizada computador foi construído na Universidade de Manchester e estava operacional em 1953; uma segunda versão foi concluída em abril de 1955. existem A máquina mais tarde utilizadas 200 transistores e 1.300 de estado sólido diodos e teve um consumo de energia de 150 watts. No entanto, ainda necessário válvulas para gerar as formas de onda de relógio a 125 kHz e para ler e escrever no magnético memória de tambor, enquanto o Harwell CADETE operado sem quaisquer válvulas usando uma frequência de relógio mais baixa, de 58 kHz quando se tornou operacional em fevereiro 1955 . Problemas com a confiabilidade dos primeiros lotes de pontos de contacto e transistores de junção ligados significava que a máquina de tempo médio entre falhas foi cerca de 90 minutos, mas isso melhorou uma vez que os mais fiáveis transistores de junção bipolar se tornou disponível.

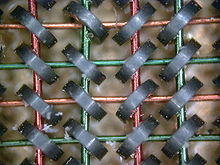

Em comparação com tubos de vácuo, transistores têm muitas vantagens: eles são menores e requerem menos energia do que os tubos de vácuo, por isso geram menos calor. Transistores de junção de silício eram muito mais confiável do que os tubos de vácuo e tinha mais tempo, por tempo indeterminado, a vida de serviço. Computadores transistorizados poderia conter dezenas de milhares de circuitos lógicos binários em um espaço relativamente compacto. Transistores reduziu muito o tamanho do seu PC, custo inicial e custo operacional. Normalmente, os computadores de segunda geração eram compostas por um grande número de placas de circuitos impressos, tais como o Sistema Modular Padrão IBM cada um carregando 03:59 portas lógicas ou flip-flops.

Um computador de segunda geração, o IBM 1401, capturou cerca de um terço do mercado mundial. IBM instalou mais de dez mil 1401s entre 1960 e 1964.

Eletrônica transistorizado melhorado não só a CPU (Central Processing Unit), mas também os dispositivos periféricos. A segunda geração de unidades de disco de armazenamento de dados capaz de armazenar dezenas de milhões de letras e algarismos. Ao lado das unidades de armazenamento em disco fixo, ligado à CPU através de transmissão de dados em alta velocidade, eram unidades de armazenamento de dados removíveis de disco. Um removível pacote de disco pode ser facilmente substituído por outro pacote em poucos segundos. Mesmo que a capacidade dos discos removíveis é menor do que discos fixos, a permutabilidade garante uma quantidade quase ilimitada de dados ao alcance da mão. A fita magnética fornecida capacidade de arquivo para esses dados, a um custo menor do que o disco.

Muitas CPUs de segunda geração delegado comunicações de dispositivos periféricos a um processador secundário. Por exemplo, enquanto o processador de comunicação controlados leitura de cartas e de perfuração, o CPU principal executados cálculos e binários instruções de desvio. Um databus iria suportar dados entre a CPU principal e memória de núcleo na CPU taxa de ciclo buscar-execução, e outros databusses normalmente servir o dispositivos periféricos. No PDP-1, tempo de ciclo do núcleo de memória foi de 5 microssegundos; consequentemente, mais instruções aritméticas levou 10 microssegundos (100.000 operações por segundo), porque a maioria das operações tomaram pelo menos dois ciclos de memória; um para a instrução, uma para o operando buscar dados.

Durante a segunda geração de unidades terminais remotas (muitas vezes sob a forma de máquinas de teletipo como um Friden Flexowriter) viu um grande aumento do uso. Ligações telefónicas fornecida velocidade suficiente para terminais remotos início e permitiu a centenas de quilômetros de separação entre terminais remotos e centro de computação. Eventualmente, estas redes de computadores autônomos iria ser generalizada em um interligada rede de redes -os Internet.

Pós-1960: terceira geração e além

A explosão na utilização de computadores começou com computadores "terceira geração", fazendo uso deJack St. Clair Kilby einvenção independente de Robert Noyce docircuito integrado(ou circuito integrado), o que levou à invenção do microprocessador.Enquanto o objecto de exatamente qual dispositivo foi o primeiro microprocessador é controverso, em parte devido à falta de acordo sobre a definição exata do termo "microprocessador", é amplamente assente que o primeiro microprocessador single-chip foi o Intel 4004, concebido e realizado porTed Hoff,Federico Faggin, e Stanley Mazor naIntel.

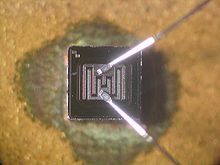

Enquanto as primeiras CIs microprocessador literalmente continham apenas o processador, ou seja, a unidade de processamento central, de um computador, o seu desenvolvimento progressivo levado naturalmente a batatas fritas que contêm a maior parte ou todos os componentes electrónicos internos de um computador. O circuito integrado na imagem do lado direito, por exemplo, um Intel 8742, é um de 8 bits microcontrolador que inclui uma CPU rodando a 12 MHz, 128 bytes de memória RAM, 2048 bytes de EPROM, e I / O no mesmo chip .

Durante os anos 1960, houve uma considerável sobreposição entre as tecnologias de segunda e terceira geração. IBM implementado seus módulos tecnologia de lógica sólida IBM em circuitos híbridos para o IBM System / 360, em 1964. Ainda em 1975, Sperry Univac continuou a fabricação de máquinas de segunda geração, tais como os UNIVAC 494. A grandes sistemas de Burroughs, como a B5000 foram máquinas de pilha, o que permitiu uma programação mais simples. Estes autômatos pushdown também foram implementados em minicomputadores e microprocessadores mais tarde, o que influenciou o projeto da linguagem de programação. Minicomputadores serviram como centros de computação de baixo custo para a indústria, empresas e universidades. Tornou-se possível simular circuitos analógicos com o programa de simulação com ênfase circuito integrado , ou SPICE (1971) em minicomputadores, um dos programas de automação de design eletrônico ( EDA). O microprocessador levou ao desenvolvimento dos microcomputadores, pequeno, computadores de baixo custo que poderiam ser de propriedade de indivíduos e pequenas empresas. Microcomputadores, a primeira das quais apareceu na década de 1970, tornou-se onipresente na década de 1980 e além.

Em abril de 1975, na Feira de Hannover, foi apresentado oP6060 produzido pelaOlivetti, primeiro computador pessoal do mundo, com built-in disquete: Unidade Central em duas placas, nomes de código PUCE1 / PUCE2,componentes TTL feita, 8 "simples ou dupladisquete discode driver, 32 caracteres alfanuméricosdisplay de plasma, 80 colunas gráficaimpressora térmica, 48 Kbytes deRAM,BASIClinguagem, 40 quilos de peso. Ele estava em concorrência com um produto similar pela IBM, mas com um disquete externo.

MOS Technology KIM-1 e Altair 8800, foram vendidos como kits para fazer-você-mesmo, como foi o Apple I, logo depois. O primeiro computador Apple com capacidades gráficas e de som saiu bem após o Commodore PET. Computing evoluiu com arquiteturas de microcomputador, com recursos adicionados de seus irmãos maiores, agora dominante na maioria dos segmentos de mercado.

Sistemas de tão complicado como computadores exigem muito alta confiabilidade. ENIAC permaneceu em, em funcionamento contínuo 1947-1955, durante oito anos antes de ser desligado. Embora um tubo de vácuo pode falhar, ele será substituído sem derrubar o sistema. Pelo simples estratégia de não desligar ENIAC, as falhas foram drasticamente reduzidos. O vácuo de tubos de computadores de defesa aérea SAGE se tornaram notavelmente confiável -. Instalados em pares, um off-line, tubos susceptíveis de falhar o fez quando o computador foi intencionalmente correr a potência reduzida para encontrá-los discos rígidos hot-pluggable, como o quente tubos de vácuo -pluggable do passado, continuar a tradição de reparo durante o funcionamento contínuo. Memórias de semicondutores rotineiramente têm nenhum erro quando operam, embora sistemas operacionais como o Unix empregaram testes de memória no start-up para detectar hardware falhando. Hoje, a exigência de um desempenho confiável torna-se ainda mais rigorosos quando farms de servidores são a plataforma de entrega. Google tem conseguido isso usando software tolerante a falhas para se recuperar de falhas de hardware, e está mesmo trabalhando no conceito de substituição farms de servidores inteiros on-the-fly, durante um evento de serviço.

No século 21, CPUs multi-core se tornou comercialmente disponível. memória de conteúdo endereçável (CAM) tornou-se barato o suficiente para ser usado em rede, embora nenhum sistema de computador ainda tem implementado CAMs de hardware para uso em linguagens de programação. Atualmente, CAMs (ou matrizes associativas) em software está programando-específico do idioma. Conjuntos de células de memória Semiconductor são estruturas muito regulares, e os fabricantes provar seus processos sobre eles; isso permite reduções de preços sobre produtos de memória. Durante os anos 1980, CMOS portas lógicas desenvolvido em dispositivos que poderiam ser feitas tão rápido quanto outros tipos de circuitos; consumo de energia do computador poderia, por conseguinte, ser reduzida drasticamente. Ao contrário do consumo de corrente contínua de um portão com base em outros tipos de lógica, uma porta CMOS só chama corrente significativa durante a "transição" entre estados lógicos, com exceção de vazamento.

Isto permitiu que a computação se tornar uma mercadoria que é agora onipresente, incorporado em muitas formas, desde cartões e telefones de satélites. hardware de computação e seu software têm até tornar-se uma metáfora para o funcionamento do universo. Embora computação baseada em DNA e computação quântica são anos ou décadas no futuro, a infra-estrutura está sendo colocada hoje, por exemplo, com origami de DNA em fotolitografia e com antenas quântica para a transferência de informações entre as armadilhas de íons. Até 2011, os pesquisadores tinham enredado 14 qubits. Rápido circuitos digitais (incluindo os baseados nas junções Josephson e rápida tecnologia quantum de fluxo único) estão se tornando mais quase realizável com a descoberta de supercondutores em nanoescala.

Fibra ótica e dispositivos fotônicos, que já foram utilizadas para transportar dados através de longas distâncias, estão agora a entrar no centro de dados, lado a lado com CPU e memória de semicondutores componentes. Isso permite a separação de RAM de CPU por interligações ópticas. A IBM criou um circuito integrado com eletrônica e óptica (isso é chamado de fotônica ) processamento de informações em um único chip. Isso é indicado "nanofotônica CMOS integrado" ou (CINP).

Uma indicação da rapidez do desenvolvimento deste campo pode ser inferido através da história do artigo seminal. No momento em que alguém teve tempo para escrever qualquer coisa para baixo, era obsoleto. Depois de 1945, outros lêem de John von Neumann primeiro rascunho de um relatório sobre a EDVAC , e imediatamente começou a implementar seus próprios sistemas. Para este dia, o ritmo de desenvolvimento tem continuado, em todo o mundo.