A multiplicação de matrizes

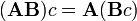

Você sabia ...

Crianças SOS feita esta seleção Wikipedia ao lado de outras escolas recursos . Um link rápido para o patrocínio criança é http://www.sponsor-a-child.org.uk/

Em matemática , a multiplicação de matrizes é a operação de multiplicação de uma matriz com qualquer um escalar ou outra matriz. Este artigo dá uma visão geral das várias formas de executar a multiplicação de matrizes.

Produto de matriz comum

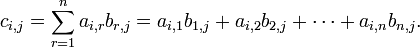

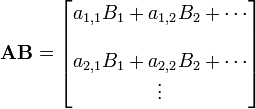

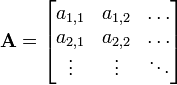

Esta é a forma mais frequentemente utilizado e mais importante para multiplicar as matrizes. Ela é definida entre duas matrizes apenas se o número de colunas da primeira matriz é o mesmo que o número de linhas da segunda matriz. Se A é uma matriz m -by- N e B é um N -by- p matriz, em seguida, o seu produto é uma matriz de m -by- p denotado por AB (ou, por vezes, A · B). Se C = AB, e c i, j representa a entrada em C na posição (i, j), então

para cada par i e j com 1 ≤ i ≤ M e 1 ≤ j ≤ p. O sistema algébrico de " unidades matriciais "resume as propriedades abstratas deste tipo de multiplicação.

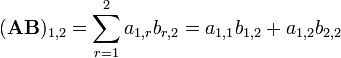

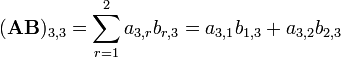

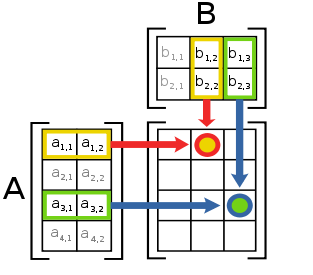

Calculando diretamente da definição

A imagem da esquerda mostra como calcular a (1,2) e o elemento (3,3) elemento de AB, se A é uma matriz 4 x 2, e B é uma matriz de 2 x 3. Os elementos de cada matriz são emparelhados na direcção das setas; cada par é multiplicado, e os produtos são adicionados. A localização do número resultante em AB corresponde a linha e coluna que foram consideradas.

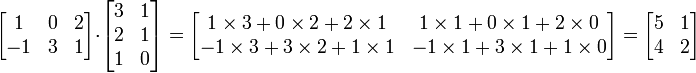

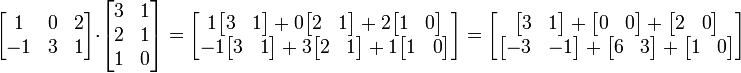

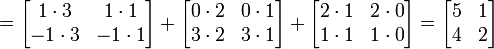

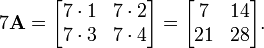

Por exemplo:

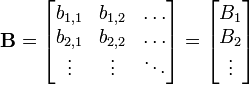

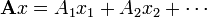

O método de coeficientes vectores

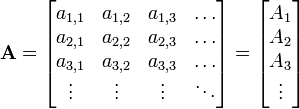

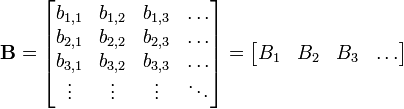

Esta multiplicação de matrizes também pode ser considerada a partir de um ponto de vista um pouco diferente: ele adiciona vetores juntos depois de ser multiplicado por diferentes coeficientes. Se A e B são matrizes dada por:

e

e

em seguida

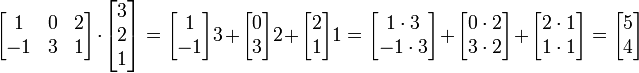

O exemplo revisitado:

As linhas na matriz à esquerda são a lista de coeficientes. A matriz da direita é a lista de vetores. No exemplo, a primeira linha é [1 0 2], e, assim, assumir um vezes o primeiro vector, 0 vezes o segundo vector, e 2 vezes o terceiro vector.

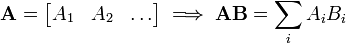

A equação pode ser ainda mais simplificado através da utilização produtos exteriores:

Os termos desta soma são matrizes da mesma forma, cada um descrevendo o efeito de uma coluna de A e B de uma linha no resultado. As colunas de A pode ser visto como um sistema de coordenadas da transformação, ou seja, dado um vetor x que têm  onde

onde  são coordenadas ao longo do

são coordenadas ao longo do  "Eixos". Os termos

"Eixos". Os termos  são como

são como  , Com excepção de que

, Com excepção de que  contém o i-ésimo de coordenadas para cada vector de coluna B, cada um dos quais é independentemente transformado em paralelo.

contém o i-ésimo de coordenadas para cada vector de coluna B, cada um dos quais é independentemente transformado em paralelo.

O exemplo revisitado:

Os vectores  e

e  foram transformados para

foram transformados para  e

e  em paralelo. Pode-se também transformá-los um por um com os mesmos passos:

em paralelo. Pode-se também transformá-los um por um com os mesmos passos:

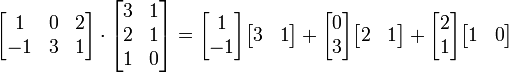

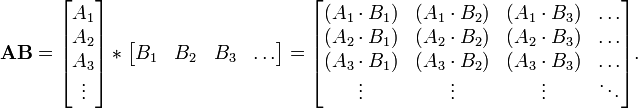

Método Vector-listas

O produto de matriz comum pode ser pensado como um de um produto escalar coluna da lista de vetores e um linha-lista de vetores. Se A e B são matrizes dada por:

e

e

onde

- Um 1 é o vector da linha de todos os elementos de uma forma 1, A 2 x é o vector da linha de todos os elementos de uma forma 2, x, etc,

- e B é um vector de todos os elementos da forma b x coluna, 1 B 2 é o vector de todos os elementos da forma b x, 2, etc. coluna,

em seguida

Propriedades

A multiplicação de matrizes não é comutativa (isto é, AB ≠ BA), exceto em casos especiais. É fácil perceber porquê: você não pode esperar para mudar as proporções com os vetores e obter o mesmo resultado. Também é fácil ver como a ordem dos factores determina o resultado quando se sabe que o número de colunas da matriz de proporções tem de ser o mesmo que o número de linhas na matriz de vectores: eles têm que representam o mesmo número de vetores.

Embora a multiplicação de matrizes não é comutativa, os determinantes de AB e BA são sempre iguais (se A e B são matrizes quadradas de mesmo tamanho). Veja o artigo sobre determinantes para uma explicação. No entanto multiplicação de matrizes é comutativa quando ambas as matrizes são diagonal e da mesma dimensão.

Esta noção de multiplicação é importante porque, se A e B são interpretados como transformações lineares (que é feito quase universalmente), em seguida, o produto de matrizes AB corresponde à composição das duas transformações lineares, com B a ser aplicado em primeiro lugar.

Além disso, todas as noções de multiplicação de matrizes descritas aqui compartilham um conjunto de propriedades comuns descritos abaixo.

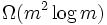

Algoritmos

O complexidade da multiplicação de matrizes, se realizada, ingenuamente, é O (n ³), mas algoritmos mais eficientes que existem. Algoritmo de Strassen, concebido por Volker Strassen em 1969 e muitas vezes referida como "a multiplicação de matrizes rápido", baseia-se em uma forma inteligente de multiplicar duas matrizes de 2 × 2, que requer apenas 7 multiplicações (em vez da habitual 8). Aplicando este truque de forma recursiva dá um algoritmo com um custo de  . Na prática, porém, é raramente utilizado, uma vez que é difícil de implementar e que carece estabilidade numérica. O fator constante implícita na notação O grande é de cerca de 4.695.

. Na prática, porém, é raramente utilizado, uma vez que é difícil de implementar e que carece estabilidade numérica. O fator constante implícita na notação O grande é de cerca de 4.695.

O algoritmo com o expoente mais baixa conhecida, que foi apresentado pelo Don Coppersmith e Shmuel Winograd em 1990 , tem uma complexidade assintótica de O (n 2.376). É semelhante ao algoritmo de Strassen: uma maneira inteligente é concebido para multiplicar dois k × k matrizes com menos de multiplicações ³ k, e esta técnica é aplicada de forma recursiva. Ele melhora no fator constante em algoritmo de Strassen, reduzindo-o a 4,537. No entanto, o termo constante implícita no O (n 2.376) resultado é tão grande que o algoritmo de Coppersmith-Winograd só vale a pena para matrizes que são grandes demais para lidar em computadores de hoje (Knuth, 1998).

Uma vez que qualquer algoritmo para multiplicar duas matrizes n × n tem de processar todos os 2 × n ² entrada, há um limite inferior de assintótica Ω (n) ² operações. Raz (2002) revela um limite inferior de  para circuitos delimitados coeficiente aritméticas sobre os números reais ou complexos.

para circuitos delimitados coeficiente aritméticas sobre os números reais ou complexos.

Cohn et al. (2003, 2005) colocar métodos, como os algoritmos de Strassen e Coppersmith-Winograd in, um completamente diferente do grupo teórico de contexto. Eles mostram que, se famílias de produtos grinalda de Abelian com grupos simétricos que satisfaçam determinadas condições existe, algoritmos de multiplicação de matrizes com complexidade quadrática essencial existir. A maioria dos pesquisadores acredita que este é realmente o caso (Robinson, 2005).

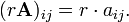

Multiplicação escalar

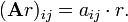

A multiplicação escalar de uma matriz A = (aij) e um escalar r r dá um produto A do mesmo tamanho que um. As entradas de r A são dados pela

Por exemplo, se

em seguida

Se estamos preocupados com matrizes mais de um anel, então a multiplicação acima é, por vezes, chamado de multiplicação enquanto a multiplicação esquerda para a direita é definido como sendo

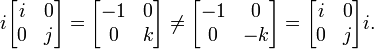

Quando o anel é subjacente conmutativo , por exemplo, o campo de número real ou complexa, as duas multiplicações são os mesmos. No entanto, se o anel não é conmutativo, tais como o quatérnions, eles podem ser diferentes. Por exemplo

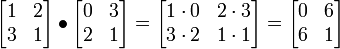

Produto Hadamard

Para duas matrizes com as mesmas dimensões, que tem o produto de Hadamard, também conhecido como o produto entrywise e o produto de Schur. Ele pode ser generalizada para reter não só para matrizes, mas também para os operadores. O Produto de Hadamard de dois m -by- n matrizes A e B, indicadas por A • B, m é um n -by- matriz dada por (A • B) ij = a ij ij b. Por exemplo

.

.

Note-se que o produto é um Hadamard submatriz do produto de Kronecker (ver abaixo).

O produto Hadamard é comutativa .

O produto Hadamard é estudada pelos teóricos da matriz, e aparece em algoritmos de compressão com perdas, como JPEG, mas é praticamente intocado pelo algebristas lineares. Discutem-se em (Horn e Johnson, 1994, cap. 5).

Produto de Kronecker

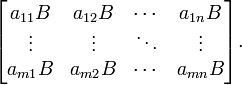

Para quaisquer duas matrizes arbitrárias A e B, temos o produto directo ou Um produto de Kronecker ⊗ B definido como

Observe que, se A é m -by- n e B é p r -by- então A ⊗ B é um p.f. -by- nr matriz. Novamente, isto não é multiplicação comutativa.

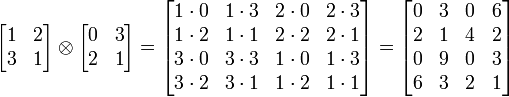

Por exemplo

.

.

Se A e B representam transformações lineares V 1 → W 1 e V 2 → W 2, respectivamente, então A ⊗ B representa o produto tensor dos dois mapas, V 1 ⊗ V 2 → W 1 ⊗ W 2.

As propriedades comuns

| O Wikibook O Livro de Provas matemáticas tem uma página sobre o tema de: As provas de propriedades de matrizes |

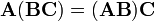

Todas as três noções de multiplicação de matrizes são associativa :

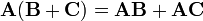

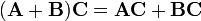

e distributiva:

e

.

.

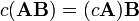

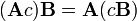

e compatível com multiplicação escalar:

Note-se que estes três pares separados de expressões irá ser iguais uns aos outros apenas se a multiplicação e adição no campo escalar são conmutativo, isto é, o campo escalar é um anel conmutativo. Veja multiplicação escalar acima de um contra-exemplo, como o campo escalar de quaternions.

Produto interno Frobenius

O produto interno Frobenius, às vezes denotado A: B é o produto interno-componente sábio de duas matrizes como se eles são vetores. Em outras palavras, é a soma das entradas do produto de Hadamard, isto é,

Este produto interno induz a Frobenius norma.